A/B testing : 5 erreurs fréquentes à ne pas commettre

L’A/B testing est utilisé par de nombreux sites web pour améliorer leur taux de conversion. Mais, si les outils d’A/B test se sont...

L’A/B testing est utilisé par de nombreux sites web pour améliorer leur taux de conversion. Mais, si les outils d’A/B test se sont...

L’A/B testing est utilisé par de nombreux sites web pour améliorer leur taux de conversion. Mais, si les outils d’A/B test se sont...

L’inbound marketing gravite autour d’une idée phare : Faites naturellement venir vos clients à vous, plutôt que...

L’inbound marketing gravite autour d’une idée phare : Faites naturellement venir vos clients à vous, plutôt que...

À l’heure des nouvelles technologies, le livre est loin d’avoir rendu l’âme. Et si vous recherchez des idées de logos sur...

Le webinar est un outil de plus en plus utilisé pour attirer des prospects et interagir avec sa clientèle. Toutefois, réussir un webinar...

Le webinar est un outil de plus en plus utilisé pour attirer des prospects et interagir avec sa clientèle. Toutefois, réussir un webinar...

Votre campagne AdWords peine à vous offrir les résultats attendus ? Votre taux de clic ne décolle pas et votre campagne votre...

Votre campagne AdWords peine à vous offrir les résultats attendus ? Votre taux de clic ne décolle pas et votre campagne votre...

Retrouvez 10 superbes mockups de véhicules : camions, camionnettes, voitures et même le célèbre van Citroën à...

L’A/B testing est utilisé par de nombreux sites web pour améliorer leur taux de conversion. Mais, si les outils d’A/B test se sont multipliés et...

L’A/B testing est utilisé par de nombreux sites web pour améliorer leur taux de conversion.

Mais, si les outils d’A/B test se sont multipliés et que la pratique s’est largement répandue, un certain nombre d’erreurs courantes subsistent parmi les gens qui le pratiquent.

Voici un éclairage sur 5 écueils plus fréquents qu’on ne pourrait le croire, et qui peuvent menacer la validité de vos tests.

Le principe même de l’A/B testing est de comparer les performances de deux variantes d’un même éléments (par exemple, deux calls to action présentés différemment mais ayant la même fonction).

Ainsi, pour mesurer avec fiabilité une différence entre ces deux variantes, il est nécessaire de bénéficier d’une base solide (ce qu’on appelle la signification statistique).

Pour mieux comprendre, on peut faire l’analogie avec un sondage : une enquête à laquelle 10 000 personnes ont répondu est, en principe, plus significative qu’une étude portant sur 100 personnes (bien que d’autres facteurs que le nombre entrent en ligne de compte).

C’est la même chose pour un A/B test : si la population sur laquelle est basé le test est trop faible, ses résultats n’auront que peu de valeur.

En définitive, l’A/B testing, malgré tous ses avantages, n’est pas forcément recommandé pour des sites à faible trafic, qui ont probablement meilleur compte à effectuer directement des changements (même radicaux) et à “voir ce qu’il se passe”.

Pour les mêmes raisons que celles énoncées plus tôt, lancer un A/B test trop tôt n’est pas pertinent.

Exemple :

Vous mettez en place un nouveau formulaire pour récolter des adresses email sur votre site. Quelques jours après, vous décidez de créer une variante avec un design légèrement différent.

Pourquoi est-ce absurde ? Parce que la version A du formulaire n’a même pas eu le temps d’engranger assez de vues pour que son taux de conversion soit significatif.

Avant de faire une comparaison, vous devez disposer d’une valeur étalon : tant que la version A n’a pas atteint un niveau de confiance suffisant, lancer une version B n’a aucun intérêt.

Moralité : ne pas lancer un A/B test prématurément.

Une étude statistique se base toujours sur une hypothèse de départ, que l’on va chercher à confirmer ou à infirmer par le biais de la recherche.

Lancer un A/B test à l’aveuglette, sans vraiment savoir ce que vous cherchez, est un mauvais calcul doublé d’une perte de temps.

Vous devez toujours avoir ne serait-ce qu’une vague idée de ce que vous voulez vérifier (ou invalider).

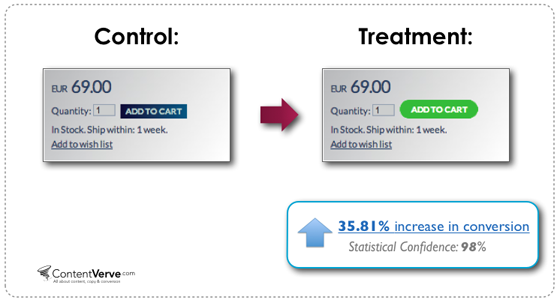

Par exemple, je peux faire l’hypothèse que changer la couleur d’un bouton va générer un taux de clics plus important. Ce n’est qu’après avoir énoncé ce postulat que je peux mettre en place un A/B test comparant deux couleurs différentes.

Source : Unbounce

Après un certain temps, je pourrai vérifier si les résultats du test valident ou invalident mon hypothèse.

Mais, combien de temps faut-il attendre, au juste ?

Cette question nous emmène à notre prochaine erreur courante.

Pour savoir combien de temps doit durer un A/B test, il nous faut revenir au concept de signification statistique.

En statistique, on ne considère jamais les résultats d’un test comme fiables à 100 %, c’est pourquoi on prévoit systématiquement une marge d’erreur.

La marge d’erreur la plus répandue est de 0, 05 : elle permet au test d’atteindre un niveau de confiance de 95 %, ce qui signifie que l’on est sûr à 95 % que ses résultats correspondent à la réalité.

Cela signifie qu’un A/B test doit a minima se poursuivre jusqu’à ce que le niveau de confiance requis (95 %, par exemple) soit atteint.

Les résultats pourront alors être considérés comme valides, ce qui ne veut pas dire qu’il faut aussitôt mettre fin au test !

Digital Marketer propose un tableau estimant la durée minimale d’un split test, en fonction du nombre de variantes testées et du nombre de conversions quotidiennes :

Par exemple, il faudrait 49 jours pour effectuer un test à 4 variantes générant 9 conversions quotidiennes, ce qui illustre bien la problématique des A/B tests trop complexes.

L’expression “A/B test” contient 2 lettres, A et B.

2 lettres, 2 variantes : inutile de tester simultanément des dizaines de possibilités.

D’abord parce que votre test risque de se transformer rapidement en usine à gaz peu compréhensible, mais aussi et surtout car plus il y a de variantes à tester, plus l’échantillon sur lequel se base l’étude doit être vaste – pour des raisons de signification statistique, encore une fois.

En d’autres termes, il faudrait un trafic très élevé (et beaucoup de temps, comme l’illustre le tableau ci-dessus) pour tester de nombreuses variables à la fois.

Néanmoins, il n’y a rien de mal à effectuer des split tests avec 3 ou 4 variantes dans certains cas – à condition d’avoir, une fois de plus, un trafic suffisant.

L’A/B testing peut sembler très simple d’accès, mais il repose sur des concepts statistiques très stricts et s’inscrit dans une démarche scientifique :

Il n’y a donc pas de place pour l’approximation, et la véracité d’un test dépend largement du respect des principes décrits plus tôt.

Abonnez-vous pour recevoir notre sélection des meilleurs articles directement dans votre boîte mail.

Nous ne partagerons pas votre adresse e-mail.